DeepL 블로그

DeepL에서는 DeepL 번역기를 비롯한 최첨단 인공지능 솔루션을 통해 글로벌 커뮤니케이션을 지원합니다. 이 블로그 페이지에서는 DeepL의 제품군과 AI 혁신에 대한 최신 정보를 제공합니다. 당사는 사람들이 언제 어디서든 AI 제품으로 원활하게 소통할 수 있도록 최선을 다하고 있습니다.

DeepL과 저희의 연혁에 대한 자세한 정보는 저희보도 자료 페이지에서 확인하실 수 있습니다.

생명과학과 언어 AI: 신속하고 규정을 준수하는 커뮤니케이션

생명과학 분야의 팀이 언어 AI를 활용해 글로벌 시장에서 더 신속하게 대응하고, 규정을 준수하며, 명확하게 소통하는 방법을 살펴보세요.

Customization hub: 브랜드 음성 및 규정 준수를 위한 AI 제어 계층

DeepL Customization hub가 다국어 콘텐츠 제작을 어떻게 혁신하는지 알아보세요. 네 가지 강력한 기능을 통해 번역물이 브랜드 목소리를 반영하고, 가이드라인을 준수하며, 시간과 비용을 크게 절감하도록 보장합니다.

적합한 API로 웹사이트를 국제적으로 확장하는 5단계 가이드

적합한 번역 API를 통해 새로운 시장을 개척하고 글로벌 영향력을 강화하세요. 이 5단계 가이드에서는 번역 요구 사항을 평가하고, 언어 품질을 균형 있게 조정하며, 캐싱 전략을 구현하고, 확장성 인프라를 구축하는 방법을 배우게 됩니다.

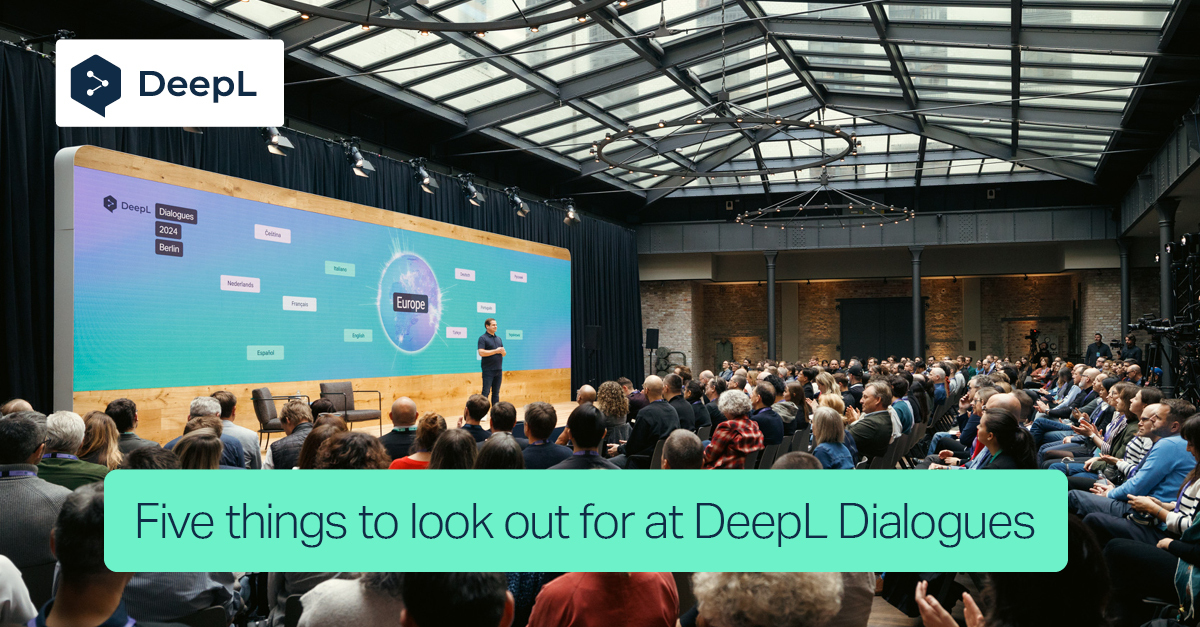

다음 주 DeepL Dialogues에서 주목해야 할 다섯 가지 주요 사항

스티브 로터는 DeepL Dialogues에서 다룰 5가지 핵심 주제를 소개합니다. 여기에는 획기적인 AI 발전과 에단 몰릭, 우주비행사 라베아 로게 같은 연사들의 전문가적 통찰이 포함됩니다.

호기심 가득한 마음을 연결하다, DeepL Bridges의 조언과 통찰

DeepL Bridges를 탐색해 보세요. 언어 및 AI 솔루션에 대한 경험과 통찰을 공유하는 사용자 커뮤니티입니다. 전문가들과 교류하고, 모범 사례를 발견하며, 언어 기술의 미래를 형성하는 토론에 기여하세요. 오늘 바로 대화에 참여하세요!

DeepL Agent로 번역을 넘어 비즈니스 과제를 해결하다

DeepL Agent로 비즈니스 미래 열어보세요. 번역을 넘어 워크플로를 향상시키도록 설계된 자율형 AI입니다. 업무를 간소화하고 생산성을 높이며 조직의 요구에 맞춰 조정하는 동시에 데이터 보안과 규정 준수를 보장하는 방법을 알아보세요.

디지털 중심 보험에서 언어 장벽을 허무는 방법

언어 AI는 보험사의 청구 처리 속도를 높이고, 규정 준수를 유지하며, 다양한 언어로 원활한 고객 서비스를 지원합니다.

DeepL의 C5 Type 2 인증 및 안전하고 규정을 준수하는 AI에 대한 우리의 약속

DeepL의 C5 Type 2 인증이 규정 산업 분야의 조직을 위한 데이터 보안을 어떻게 강화하는지 알아보세요. Bring Your Own Key 암호화(BYOKE)와 같은 고급 기능에 대해 최신 정보를 확인하고, DeepL이 AI 솔루션에서 규정 준수 및 신뢰성을 어떻게 보장하는지 확인하세요.

Meet DeepL: 뿌리와 길로 문화와 유대를 기리며

DeepL의 Roots & Routes 직원 네트워크 그룹(ERG)이 모자이크 페스트를 통해 다양성을 어떻게 기념하는지 알아보세요. 이 페스트는 문화, 유대감, 소속감을 생동감 넘치게 선보이는 행사입니다.

FP8을 활용한 훈련 및 추론을 통해 DeepL 차세대 대규모 언어 모델(LLM)을 구축한 방법

DeepL이 차세대 대규모 언어 모델(LLM)의 훈련 및 추론에 FP8을 활용하여 처리량과 모델 품질을 향상시킨 방법을 알아보세요. NVIDIA 기술과 함께한 우리의 여정에 대해 최신 정보를 알아보세요. 낮은 지연 시간을 유지하면서 더 빠른 훈련과 우수한 번역을 달성했습니다.